Έχει τελειώσει. Θα την πατήσετε – ίσως ήδη να έχει συμβεί. Τους τελευταίους έξι μήνες, οι γεννήτριες βίντεο με τεχνητή νοημοσύνη έχουν εξελιχθεί τόσο πολύ, που η σχέση μας με τις κάμερες αλλάζει ριζικά. Στο καλύτερο σενάριο, θα ξεγελαστείτε ξανά και ξανά, μέχρι να αρχίσετε να αμφισβητείτε κάθε τι που βλέπετε. Καλωσορίσατε στο μέλλον.

Προς το παρόν, υπάρχουν ακόμη ορισμένα «καμπανάκια» που μπορείτε να εντοπίσετε. Ένα ξεχωρίζει: αν δείτε ένα βίντεο με κακή ποιότητα εικόνας – θολό, κοκκώδες – καλό είναι να υποψιαστείτε ότι ίσως πρόκειται για δημιουργία AI.

«Είναι από τα πρώτα πράγματα που εξετάζουμε», λέει ο Hany Farid, καθηγητής πληροφορικής στο Πανεπιστήμιο της Καλιφόρνια, Μπέρκλεϊ, πρωτοπόρος στην ψηφιακή εγκληματολογία και ιδρυτής της εταιρείας ανίχνευσης deepfake GetReal Security.

Η δυσάρεστη αλήθεια είναι πως τα εργαλεία βίντεο AI θα γίνουν ακόμη καλύτερα και αυτή η συμβουλή σύντομα θα πάψει να ισχύει – ίσως σε λίγους μήνες, ίσως σε χρόνια. Είναι αδύνατο να προβλέψουμε! Ωστόσο, αν δώσετε σημασία στη λεπτομέρεια, αυτό το tip μπορεί να σας προστατεύσει από ψεύτικα βίντεο μέχρι να αλλάξετε εντελώς τον τρόπο που αντιλαμβάνεστε την αλήθεια.

Για να είμαστε σαφείς: αυτό δεν αποτελεί απόδειξη. Τα βίντεο AI δεν είναι απαραίτητα κακής ποιότητας. Τα καλύτερα εργαλεία μπορούν να παράγουν εντυπωσιακά, άψογα κλιπ. Αντίστοιχα, ένα χαμηλής ποιότητας βίντεο δεν σημαίνει απαραίτητα ότι είναι ψεύτικο ή ύποπτο.

«Αν δείτε κάτι πολύ χαμηλής ποιότητας, δεν σημαίνει ότι είναι ψεύτικο ή ότι υπάρχει δόλος», σημειώνει ο Matthew Stamm, καθηγητής και επικεφαλής του Εργαστηρίου Ασφάλειας Πολυμέσων στο Drexel University των ΗΠΑ.

Το θέμα είναι ότι τα θολά, pixelated βίντεο AI είναι αυτά που έχουν τη μεγαλύτερη πιθανότητα να σας ξεγελάσουν – τουλάχιστον προς το παρόν. Είναι ένδειξη ότι αξίζει να προσέξετε καλύτερα τι παρακολουθείτε.

Η τεχνητή νοημοσύνη εξακολουθεί να προσθέτει παραμορφώσεις στα βίντεο, αλλά αυτές γίνονται όλο και πιο δύσκολο να εντοπιστούν. Όταν το κλιπ είναι χαμηλής ποιότητας, οι «κόκκινες σημαίες» περνούν πιο εύκολα απαρατήρητες.

Τα νέα σημάδια και οι τεχνικές παραπλάνησης

«Οι κορυφαίες γεννήτριες κειμένου-σε-βίντεο όπως το Veo της Google και το Sora της OpenAI εξακολουθούν να εμφανίζουν μικρές ασυνέπειες», τονίζει ο Farid. «Δεν μιλάμε πια για έξι δάχτυλα ή παραμορφωμένα γράμματα – οι αστοχίες είναι πολύ πιο διακριτικές».

Ακόμη και τα πιο εξελιγμένα μοντέλα σήμερα συχνά εισάγουν περίεργα στοιχεία: υπερβολικά λείο δέρμα, αφύσικα μοτίβα σε μαλλιά ή ρούχα ή αντικείμενα στο φόντο που κινούνται με παράδοξο τρόπο. Όλα αυτά μπορεί εύκολα να διαφύγουν της προσοχής μας· όσο πιο καθαρή η εικόνα, τόσο πιθανότερο να εντοπίσετε τέτοιες ενδείξεις.

Αυτός είναι ο λόγος που τα βίντεο χαμηλής ποιότητας γίνονται ιδιαίτερα «επικίνδυνα». Αν ζητήσετε από την AI ένα αποτέλεσμα που μοιάζει τραβηγμένο με παλιά κάμερα ή κινητό χαμηλής ανάλυσης, τα ψηφιακά ψεγάδια κρύβονται αποτελεσματικά.

Τους τελευταίους μήνες, αρκετά viral βίντεο AI εξαπάτησαν εκατομμύρια ανθρώπους. Όλα είχαν ένα κοινό χαρακτηριστικό: μια ψεύτικη σκηνή με άγρια κουνέλια σε τραμπολίνο συγκέντρωσε πάνω από 240 εκατομμύρια προβολές στο TikTok. Εκατομμύρια χρήστες λάτρεψαν ένα ρομαντικό στιγμιότυπο δύο αγνώστων στο μετρό της Νέας Υόρκης – μόνο για να απογοητευτούν όταν αποκαλύφθηκε ότι ήταν επίσης ψεύτικο.

Ο ίδιος ο συντάκτης εξομολογείται πως ξεγελάστηκε από ένα viral βίντεο με έναν Αμερικανό ιερέα σε συντηρητική εκκλησία που έκανε ένα εντυπωσιακά αριστερό κήρυγμα: «Οι δισεκατομμυριούχοι είναι η μόνη μειονότητα που πρέπει να φοβόμαστε! Έχουν τη δύναμη να καταστρέψουν τη χώρα!» Ένιωσε έκπληξη – μήπως θόλωσαν τόσο πολύ τα πολιτικά όρια; Όχι. Ήταν απλώς ακόμη ένα δημιούργημα της AI.

Γιατί τα σύντομα και χαμηλής ανάλυσης βίντεο ξεγελούν

Όλα αυτά τα βίντεο είχαν ένα κοινό: έμοιαζαν τραβηγμένα με «πατάτα». Τα κουνέλια του AI παρουσιάστηκαν ως νυχτερινή λήψη από φθηνή κάμερα ασφαλείας. Το ζευγάρι του μετρό ήταν γεμάτο pixels. Ο φανταστικός ιερέας φαινόταν σαν το πλάνο να είχε γίνει υπερβολικό ζουμ.

Υπήρχαν κι άλλες ενδείξεις. «Τα τρία βασικά στοιχεία που πρέπει να εξετάζετε είναι η ανάλυση, η ποιότητα και η διάρκεια», εξηγεί ο Farid. Η διάρκεια είναι το πιο εύκολο: «Συνήθως τα AI βίντεο είναι πολύ σύντομα – ακόμη πιο μικρά κι από τα συνηθισμένα TikTok ή Instagram βίντεο των 30-60 δευτερολέπτων. Τα περισσότερα που μου ζητούν να ελέγξω έχουν διάρκεια έξι, οκτώ ή δέκα δευτερολέπτων».

Αυτό συμβαίνει επειδή η παραγωγή τέτοιων βίντεο κοστίζει πολύ· έτσι τα περισσότερα εργαλεία περιορίζονται στα σύντομα κλιπ. Όσο μεγαλύτερη η διάρκεια, τόσο πιθανότερο η AI να κάνει λάθος – αν ενώσετε πολλά μικρά κλιπ μαζί, θα παρατηρήσετε κοψίματα κάθε λίγα δευτερόλεπτα.

Η ανάλυση και η ποιότητα σχετίζονται αλλά δεν ταυτίζονται: η ανάλυση αφορά τον αριθμό των pixels μιας εικόνας· η συμπίεση μειώνει το μέγεθος του αρχείου πετώντας λεπτομέρειες και αφήνοντας πίσω μπλοκαρισμένες υφές και θολές άκρες.

Ο Farid εξηγεί πως οι κακόβουλοι χρήστες συχνά υποβαθμίζουν σκόπιμα την ποιότητα των ψεύτικων τους: «Αν θέλω να εξαπατήσω τον κόσμο; Παράγω το ψεύτικο βίντεό μου με υψηλή ποιότητα και μετά μειώνω την ανάλυση ώστε να φαίνεται αλλά χωρίς πολλές λεπτομέρειες. Στη συνέχεια εφαρμόζω συμπίεση για να θολώσω περαιτέρω τυχόν ψηφιακά ψεγάδια». Πρόκειται για συνήθη πρακτική.

Το μέλλον της επαλήθευσης και ο νέος ρόλος του θεατή

Το πρόβλημα μεγαλώνει όσο οι κολοσσοί της τεχνολογίας επενδύουν δισεκατομμύρια για ακόμα πιο ρεαλιστικά αποτελέσματα μέσω AI. «Έχω δυσάρεστα νέα», προειδοποιεί ο Stamm. «Αν αυτά τα οπτικά σημάδια υπάρχουν τώρα, σύντομα θα εξαφανιστούν – ήδη έχουν χαθεί στις φωτογραφίες που παράγει η AI. Δεν μπορούμε πια να εμπιστευόμαστε μόνο τα μάτια μας».

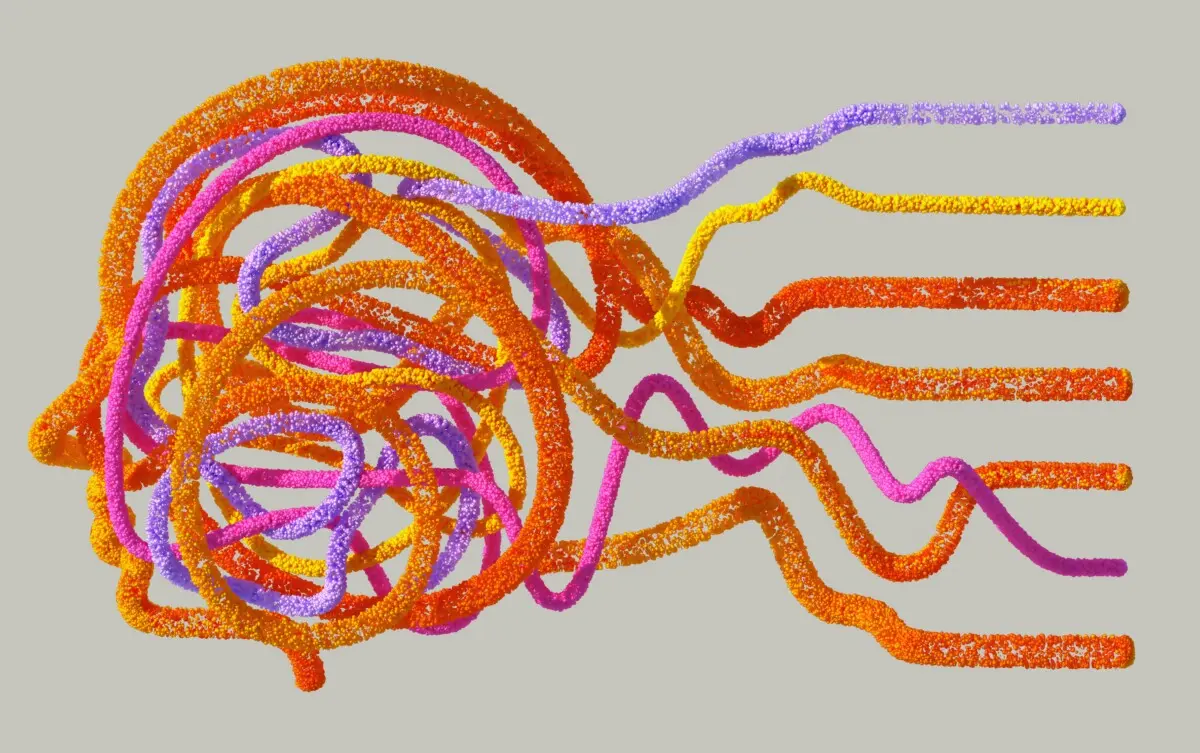

Ωστόσο αυτό δεν σημαίνει πως η αλήθεια χάνεται οριστικά. Οι ερευνητές όπως οι Farid και Stamm διαθέτουν πλέον εξελιγμένες τεχνικές επαλήθευσης περιεχομένου: «Όταν παράγεται ή τροποποιείται ένα βίντεο, αφήνει πίσω του μικροσκοπικά στατιστικά ίχνη – σαν δακτυλικά αποτυπώματα σε σκηνή εγκλήματος», εξηγεί ο Stamm. Αναπτύσσονται τεχνικές για την ανίχνευση αυτών των «δακτυλικών αποτυπωμάτων».

Για παράδειγμα, η κατανομή των pixels σε ένα ψεύτικο βίντεο μπορεί να διαφέρει από ένα αυθεντικό – όμως τίποτα δεν είναι αλάνθαστο. Παράλληλα οι εταιρείες τεχνολογίας εργάζονται σε νέα πρότυπα επαλήθευσης: για παράδειγμα κάμερες θα μπορούσαν να ενσωματώνουν πληροφορίες αυθεντικότητας κατά τη λήψη μιας εικόνας ή ενός βίντεο· αντίστοιχα τα εργαλεία AI θα μπορούσαν αυτόματα να προσθέτουν στοιχεία που δηλώνουν ότι το περιεχόμενο είναι τεχνητό.

Η πραγματική λύση, σύμφωνα με τον ειδικό ψηφιακού γραμματισμού Mike Caulfield, είναι όλοι μας να αλλάξουμε τον τρόπο που σκεφτόμαστε όσα βλέπουμε online. Η αναζήτηση των ψηφιακών ιχνών της AI δεν αποτελεί διαρκή λύση γιατί αυτά συνεχώς μεταβάλλονται.

Ο Caulfield υποστηρίζει πως πρέπει πλέον να εγκαταλείψουμε την ιδέα ότι μια εικόνα ή ένα βίντεο έχει οποιαδήποτε αξία εκτός συμφραζόμενων: «Μακροπρόθεσμα το σημαντικό θα είναι η προέλευση του περιεχομένου κι όχι τα επιφανειακά χαρακτηριστικά του». Θα πρέπει δηλαδή πάντα να ερευνούμε την πηγή ενός υλικού κι όχι απλώς όσα φαίνονται στην οθόνη μας.

You’d never look at a piece of text and assume it’s true just because someone wrote it down…

Θα ερευνήσετε την πηγή μιας είδησης πριν την πιστέψετε – έτσι πρέπει πλέον να λειτουργείτε και με τις εικόνες ή τα βίντεο στο διαδίκτυο αφού πλέον μπορούν εύκολα να παραποιηθούν ή πλαστογραφηθούν από την τεχνητή νοημοσύνη. Το μόνο που έχει σημασία πλέον είναι ποιος ανέβασε το περιεχόμενο, ποιο είναι το πλαίσιο δημοσίευσης και αν έχει επαληθευτεί από αξιόπιστη πηγή.

«Αν μου επιτρέπετε λίγη υπερβολή», καταλήγει ο Stamm, «πιστεύω πως πρόκειται για τη μεγαλύτερη πρόκληση στην ασφάλεια πληροφορίας του 21ου αιώνα». Το πρόβλημα αυτό εμφανίστηκε μόλις πριν λίγα χρόνια· όσοι εργάζονται πάνω στη λύση του αυξάνονται γρήγορα αλλά ακόμα παραμένουν λίγοι συγκριτικά με τις ανάγκες. Θα χρειαστεί συνδυασμός λύσεων, εκπαίδευσης, έξυπνων πολιτικών και τεχνολογικών εργαλείων για την αντιμετώπισή του – όμως υπάρχει ακόμη ελπίδα.»

*Ο Thomas Germain είναι ανώτερος τεχνολογικός συντάκτης του BBC με ειδικότητα στην τεχνητή νοημοσύνη.

Πηγή: BBC